Se denomina espectro visible y a veces simplemente luz visible a la región de la radiación que el ojo humano es capaz de percibir. Las diferentes radiaciones se distinguen por la distancia entre dos picos consecutivos de la onda -la longitud de onda- y los límites que podemos ver van de los 400 nanómetros del violeta a los 700 nanómetros de rojo, aunque los límites no son exactos y pueden variar mínimamente entre personas.

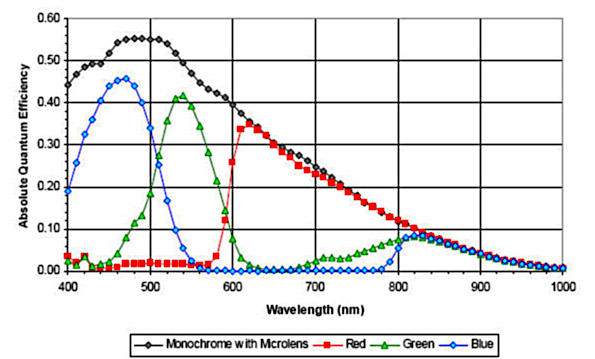

Los sensores -ya sean CCD, CMOS o del tipo que sean- tratan de reproducir el patrón del ojo humano para que lo que obtengamos se parezca lo más posible a la visión directa. Para ello se fabrican sensibles a la luz visible, pero también lo son a lo que sucede en los bordes del espectro visible. Al igual que sucede con algunas películas fotoquímicas los sensores digitales también ‘ven’ las bandas cercanas de ultravioleta y de infrarrojo.

Los sensores -ya sean CCD, CMOS o del tipo que sean- tratan de reproducir el patrón del ojo humano para que lo que obtengamos se parezca lo más posible a la visión directa. Para ello se fabrican sensibles a la luz visible, pero también lo son a lo que sucede en los bordes del espectro visible. Al igual que sucede con algunas películas fotoquímicas los sensores digitales también ‘ven’ las bandas cercanas de ultravioleta y de infrarrojo.

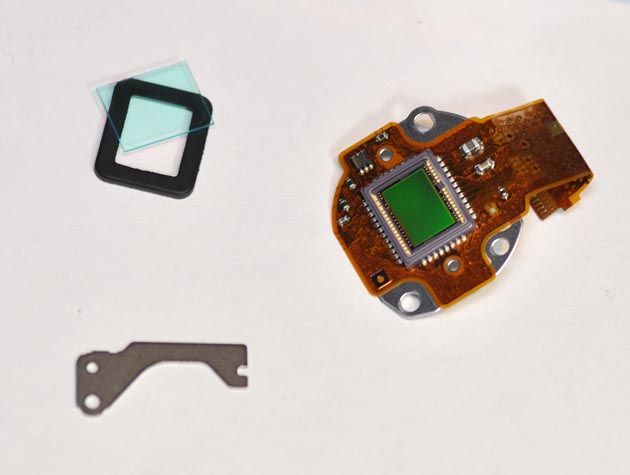

Para que esto no afecte a la imagen tomada, por delante del sensor se sitúan filtros que no dejan pasar ni la luz ultravioleta ni la luz infrarroja. Un caso conocido de fallo en esta tarea es lo que sucedió con la Leica M8. Su sensor no filtraba adecuadamente la luz infrarroja y las imágenes tenían en ocasiones un tono magentoso. La solución era poner un filtro por delante de la lente.

La respuesta de un sensor típico a las diferentes frecuencias sería la línea de puntos negros del siguiente gráfico.

Los sensores digitales no distinguen los colores, sólo son capaces de ver si reciben, o no, una cierta cantidad de luz. El nuevo sensor Phase One Achromatic Plus funciona de ese modo, y obtiene imágenes en blanco y negro como las obtendría un carrete de Tri-X.

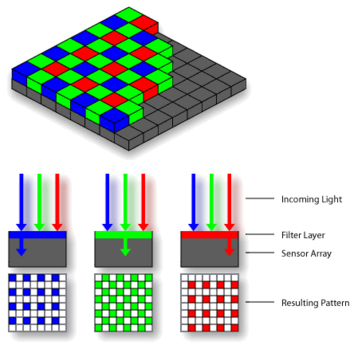

Si queremos que nuestra cámara distinga colores es necesario filtrarlos. Colocando filtros de colores delante de los píxeles podemos conseguir que una parte ‘vea’ solo el color verde, una parte el rojo y una parte el azul. Con la combinación de los tres colores (RGB en inglés) se forma cualquier otro. Unas células de nuestra retina llamadas conos hacen exactamente el mismo trabajo. Los filtros están repartidos formando un mosaico llamado patrón Bayer.

Si colocamos un filtro por delante y quitamos la luz ultravioleta y la luz infrarroja, voilà, ya tenemos un dispositivo que se comporta a imagen y semejanza del ojo humano.

Si colocamos un filtro por delante y quitamos la luz ultravioleta y la luz infrarroja, voilà, ya tenemos un dispositivo que se comporta a imagen y semejanza del ojo humano.

Pero nuestra intención -científica o estética- puede ser otra. Quizás no queremos reproducir lo que vemos sino probar otras cosas. Después del desástrofe de desmontar una Lumix LX3 para limpiarla y no conseguir que volviese a ser la misma la transformé para ver luz infrarroja. Le quité el filtro que está delante del sensor y bloquea el infrarrojo, y por delante de la lente puse uno que no deja pasar la luz visible. El mío concretamente no deja pasar luz de 850 nanómetros para abajo, pero los he visto de 720 y de 950. Una prueba sencilla se puede hacer con un filtro casero hecho con un negativo negro. El problema es que si nuestra cámara sigue teniendo el filtro del sensor es que recibirá tan poca luz que tendremos que ir a tiempos de exposición muy altos, mientras que en una cámara modificada como mi Lumix son tiempos normales (entre 1/100 y 1/400).

Ahora mi cámara sólo ve la luz infrarroja aunque no toda, sólo la que está cerca del espectro visible a la que es sensible el sensor de la Lumix. Como los filtros R, G y B de mosaico bayer dejan pasar más o menos la misma cantidad de luz infrarroja, el resultado es monocromo, y si hacemos un pre-balance de blancos sobre una zona de césped, en la pantalla también lo parecerá.

Quizás lo más característico de estas imágenes es la respuesta de las plantas, que en ocasiones reflejan tanto infrarrojo que parecen blancas, con un resultado más propio de navidad que del día casi veraniego que disfrutamos en Coruña el sábado. También una cosa curiosa es que en los días nublados el contraste en estas fotografías es muy bajo, y con el sol directo y a mediodía el rango dinámico ‘cabe’ en el sensor y los resultados son más interesantes.

Por Félix Sánchez-Tembleque (wiggin)

![[EXPOSICIÓN] Wildlife Comedy Parque Cristina Enea. Donostia.](https://www.caborian.com/wp-content/uploads/2022/02/IGELA02pisu-150x150.jpg)

![[Fotógrafos] Scott Barbour](https://www.caborian.com/wp-content/uploads/2022/01/scott_barbour-150x150.jpg)

![[Fotógrafos] Bruno Abarca. El difícil acceso a la salud de los refugiados](https://www.caborian.com/wp-content/uploads/2016/04/bruonoat_1-150x150.jpg)