De las dos posibles fuentes de movimiento que afectan a la nitidez de una imagen -fotógrafo y motivo fotografiado- llamamos trepidación a la que se produce por el movimiento de la cámara. Velocidades de disparo muy bajas nos llevan a imágenes poco nítidas lo cual no tiene porqué ser un problema si es que ese era nuestro propósito creativo tal y como vimos en el LAB, del que extraemos este texto:

Para evitar la falta de nitidez por culpa del movimiento de la cámara –que llamamos trepidación-, la regla clásica de los manuales de fotografía dice que para disparar una cámara de 35mm sostenida con las manos con una distancia focal X es necesario disparar a una velocidad más rápida de 1/X. Tomando esto sólo como una referencia -válida según mi punto de vista, si sostenemos la cámara con una técnica adecuada- y no como una verdad absoluta, con la llegada de la fotografía digital tememos nuevos factores en juego

- Los objetivos y cuerpos con estabilización de imagen que permiten bajar hasta 4 puntos (son suerte y práctica) sobre esa velocidad.

- Las cámaras con sensor de tamaño diferente al negativo de 35mm. Puesto que lo importante es el movimiento en términos de ángulo, debe considerarse la focal equivalente. Para APS-C hay que subir un punto, y para 4/3, dos puntos.

- La resolución del sensor, una variación que no es apreciable en un sensor de 8 megapíxels sí puede serlo en uno de 20. También sucede lo contrario, mi experiencia es que las compactas de 3 mpix pueden dispararse con cierto cuidado a 1/8 y las de 6 a 1/15 en su posición angular.

La llegada de las cámaras réflex digitales ha modificado la regla clásica de la inversa de la focal en dos sentidos, ambos relacionados por un mismo factor: la densidad de píxeles. Tal y como digimos entonces, el tamaño del sensor y su resolución nos afectan. Un sensor más pequeño con mayor número de píxels tiene más densidad. Si un teleobjetivo de 200mm podía dispararse a velocidad de 1/200 en una réflex con película de 35, montado por ejemplo sobre una Canon EOS 7D (formato APS-C y 18mpix) debería dispararse por encima de 1/400. Un paso de exposición más por la multiplicación de focal y otro por los 18mpix.

Afortunadamente una gran parte de los objetivos con más problemas en este sentido -las focales más largas- disponen ahora de mecanismos de estabilización que compensan los movimientos y permiten disparar con velocidades hasta 4 puntos de exposición más bajas en el mejor de los casos. Estos objetivos disponen de un pequeño grupo de lentes que se desplazan para hacer esa corrección. Existe también otra aproximación al problema con cuerpos de cámara que integran el mecanismo de estabilización. En este caso lo que se desplaza para compensar el movimiento de la cámara es el propio sensor de imagen. La principal desventaja del segundo sistema es que la compensación no se ve en el visor, donde la falta de nitidez es más evidente. La principal ventaja es que es compatible con cualquier lente, incluidas las que integran estabilización. Estos mecanismos de estabilización sin embargo suponen un coste extra en los objetivos y los cuerpos, y además pueden degradar la imagen y en particular el bokeh, las figuras que se producen en los elementos desenfocados. Si el estabilizador no es necesario debe ser desconectado siempre. Además estaremos ahorrando batería.

Los mecanismos de estabilización dependen de un sensor que mide los movimientos de la cámara para compensarlos. Estos sensores que eran terriblemente caros (y lo siguen siendo cuando deben ser muy precisos, como los que integran los navegadores inerciales de los aviones) han bajado mucho su precio y ahora están integrados hasta en muchos teléfonos como el iPhone.

Lo que hemos visto esta semana es la presentación por parte de Microsoft (aquí se puede leer el documento original vía Thom Hogan) de un algoritmo matemático para corregir esa falta de nitidez a posteriori de tomar la imagen, es decir, procesar una imagen para mejorar su nitidez. En realidad no es nada nuevo y está integrado en sistemas de fotografía aérea desde hace tiempo.

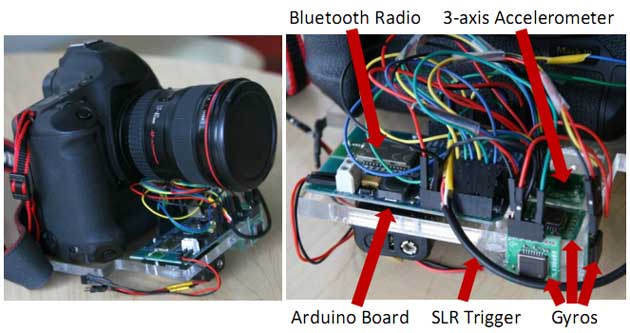

Cuando disparamos a una velocidad más baja de la debida, el movimiento de la cámara se traduce en algo parecido a una serie de imágenes montadas unas encima de otras en diferente posición, produciendo una imagen borrosa. Matemáticamente, este proceso se llama convolución, y deshacerlo deconvolución. Para poder deshacer el proceso es necesario conocer cómo se movió la cámara en el momento de la toma, los autores del trabajo incluyeron un sensor para medir este movimiento basado en la plataforma Photoduino de la que ya os hablamos.

El montaje es muy aparatoso pero ha servido para demostrar la efectividad del sistema, en una aplicación real podría usarse el sensor de un iPhone integrado en el cuerpo de cámara y grabar los datos de movimiento en los EXIF, y los resultados en algunos casos mejoran a los de la estabilización integrada en objetivos o cuerpo. ¿Veremos pronto estos sistemas en nuestras cámaras?